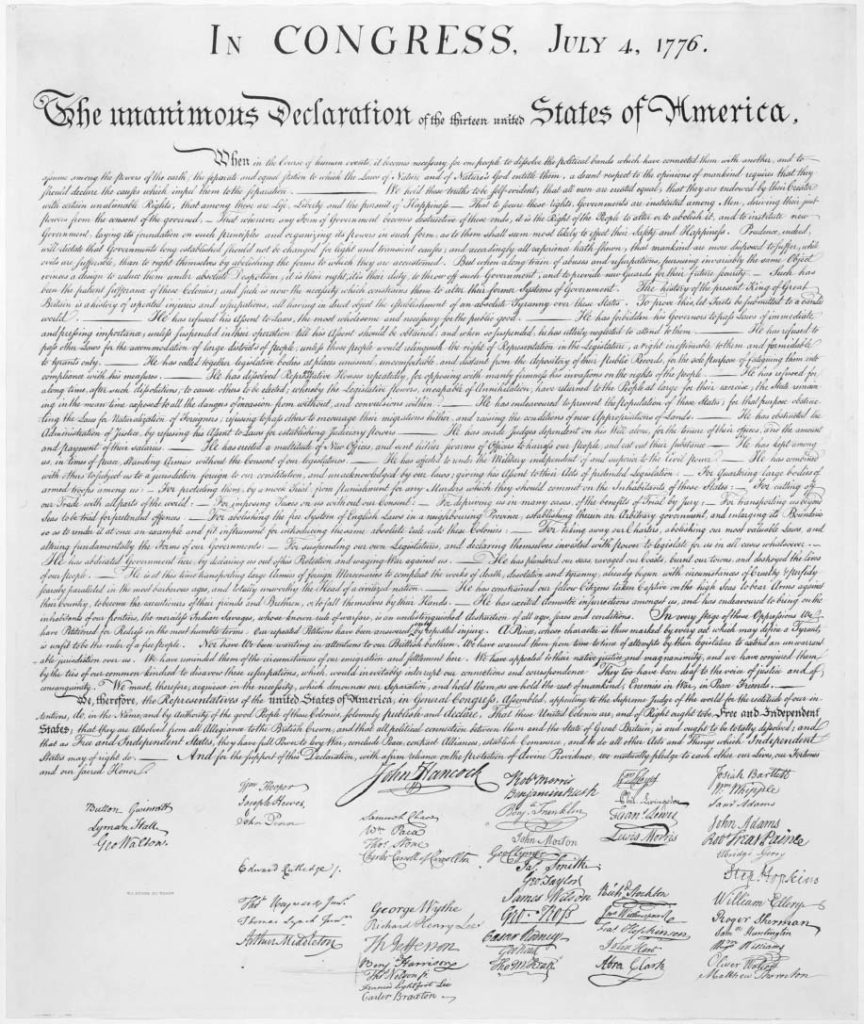

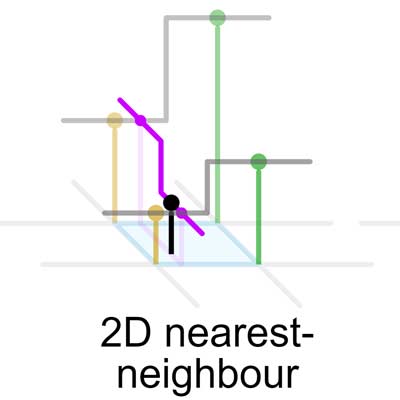

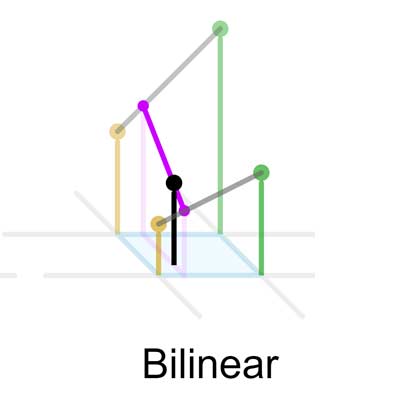

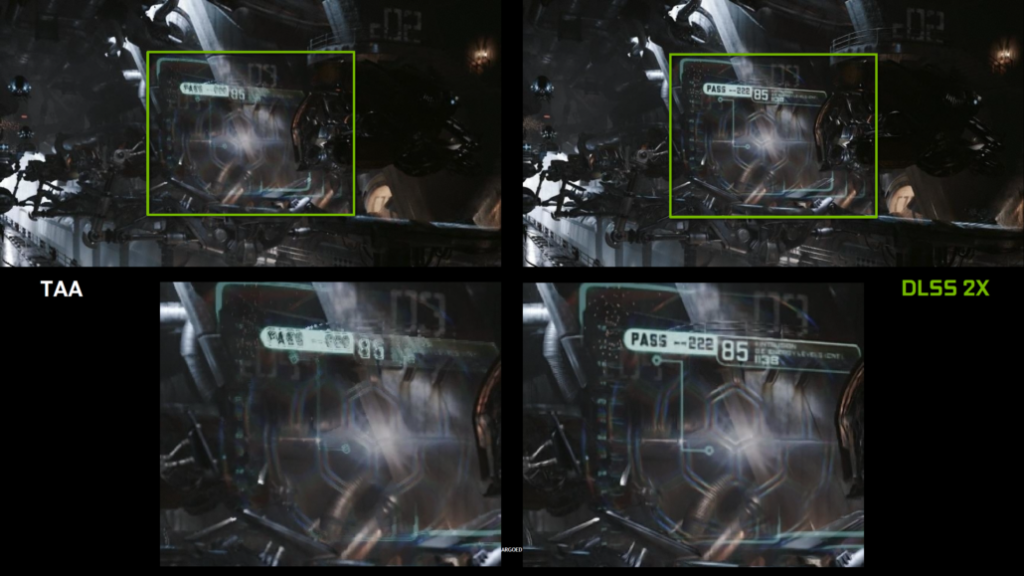

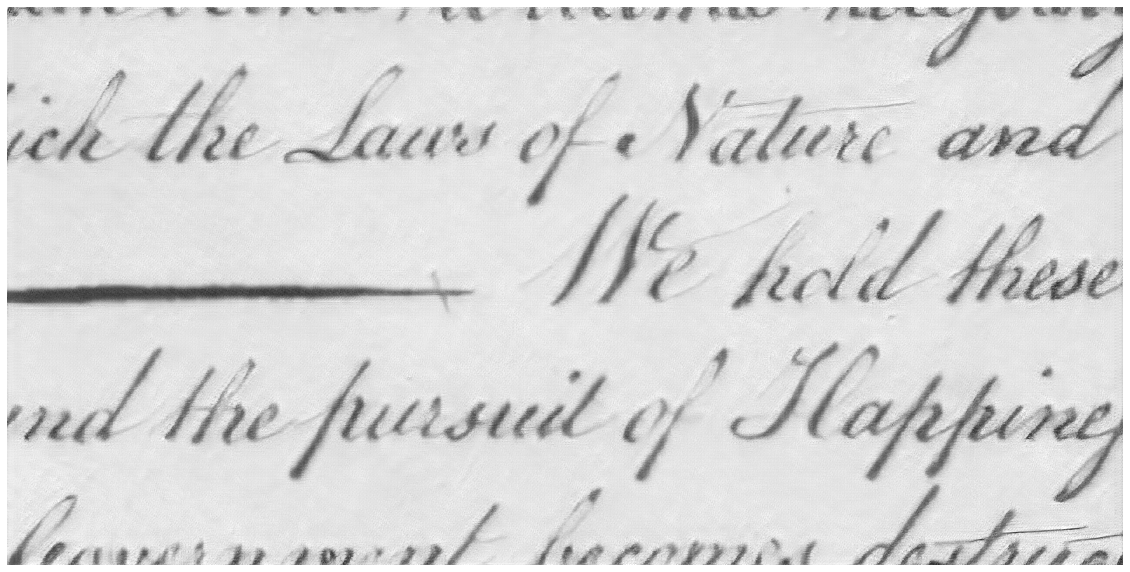

Purtroppo, il processo di upscaling della computer graphics in tempo reale ha alcuni vantaggi. Per esempio, di solito si hanno diverse immagini in una sequenza che possono essere usate per estrarre informazioni aggiuntive che possono venir perse nelle singole immagini. Si possono anche usare informazioni aggiuntive fornite dal motore di rendering, come i vettori di movimento o anche gli stencil degli oggetti. Quando abbiamo a che fare con pagine scannerizzate di vecchi documenti, non abbiamo nessuna di queste cose. Abbiamo solo un'immagine, e dobbiamo "immaginare" qualsiasi tipo di informazione extra. Fortunatamente, questa è un'area dove l'IA ha avuto successo . Questo particolare sottocampo ha fatto uso dei cosiddetti Reti Adversariali Generative, e mentre ancora non vengono realmente applicate in ambienti di produzione, mostrano un notevole potenziale. Funzionano impiegando due reti neurali separate: Un generatore e un discriminatore. Nel caso d'uso più comune, il generatore crea nuove immagini, mentre il discriminatore cerca di individuare le immagini false tra quelle reali da un dato set di dati di addestramento. Il processo di addestramento è un gioco a somma zero in cui una rete diventa più brava a falsificare le immagini mentre l'altra diventa più brava a identificare i falsi. Se addestrate abbastanza a lungo, le GAN hanno dimostrato di produrre risultati fotorealistici. Se vogliamo creare immagini completamente nuove, dovremmo essenzialmente fornire dati casuali al generatore come input. Questo è molto interessante per gli artisti o i content creators, ma in realtà vogliamo migliorare immagini esistenti . Per farlo, abbiamo bisogno di un setup leggermente modificato, per il quale abbiamo dato un'occhiata più da vicino all'architettura descritta in questo articolo: Super-risoluzione di una singola immagine foto-realistica utilizzando una rete generativa avversaria GAN. I dettagli sono un po' troppo complicati per questo post, ma i risultati parlano da soli.